La seconda settimana del mese di ottobre è tradizionalmente dedicata agli annunci ufficiali dell’assegnazione dei Premi Nobel. Il primo premio che viene assegnato è sempre quello per la Medicina, cui seguono, in ordine, quelli per la Fisica e la Chimica, che poi sono i premi che a noi interessano maggiormente. Almeno per questo articolo.

La seconda settimana del mese di ottobre è tradizionalmente dedicata agli annunci ufficiali dell’assegnazione dei Premi Nobel. Il primo premio che viene assegnato è sempre quello per la Medicina, cui seguono, in ordine, quelli per la Fisica e la Chimica, che poi sono i premi che a noi interessano maggiormente. Almeno per questo articolo.

In particolare in questo 2024 i due premi Nobel sono legati a doppio filo da una tematica che è ultimamente spesso sulla bocca di tutti: le reti neurali e l’intelligenza artificiale. Anche noi su EduINAF stiamo iniziando a interessarci del tema, basti vedere le immagini che accompagnano gli articoli de Lo spazio tra le pagine, la rubrica di Marco Castellani, o alcuni articoli specifici che sia lo stesso Marco (leggi, per esempio, Campagne astrali, cosmi artificiali), sia l’altra colonna delle nostre rubriche, Stefano Sandrelli, hanno specificatamente dedicato alla faccenda (per esempio in Dialogando di De Andrè con chatGPT). Per cui ho pensato bene di dedicare nel corso di questra “Settimana da Nobel” un articolo ai vincitori dei premi Nobel 2024, sia per raccontare, nei limiti del possibile, la matematica delle reti neurali, sia per sottolineare le basi fisiche che hanno permesso alle ricerche nel campo dell’intelligenza artificiale di ottenere un boost importante.

Prima di iniziare, però, facciamo un breve recap dei vincitori e delle motivazioni:

Premi Nobel per la Chimica 2024 a David Baker per la progettazione computazionale delle proteine e Demis Hassabis e John Jumper per le predizioni sulla struttura delle proteine.

Tutto inziò con sette ponti

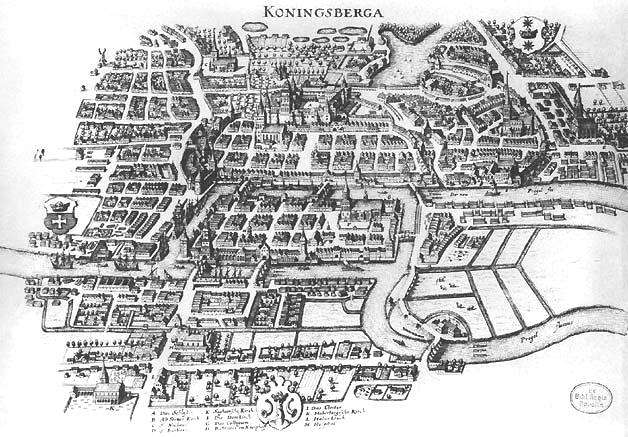

La nostra storia inizia nel 1736 quando Leonhard Euler risolse il famoso problema dei sette ponti di K\”onigsberg, ridente cittadina della Prussia (oggi Kaliningrad in Russia). Il problema che gli era stato posto era piuttosto semplice: la città era attraversata da un fiume, al cui centro c’era (e c’è ancora) un’isola che era collegata con le due rive da un sistema di sette ponti. Era possibile attraversarli tutti senza passare più di una volta su ciascun ponte?

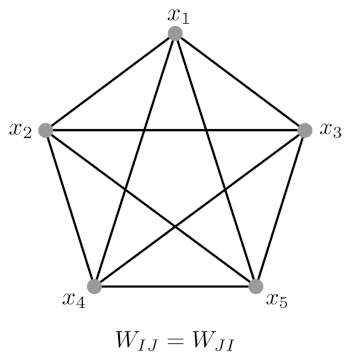

La risposta, negativa, diede il via a quella che è oggi nota come teoria dei grafi, che descrive una rete di nodi connessi uno con l’altro da uno o più percorsi. Aggiungendo un po’ di matematica(1)A puro titolo di esempio vi mostro un’equazione tipica della teoria delle reti:

\(\sum_{i=1}^n a_i w_{ij}\)

per descrivere i nodi e come essi interagiscono uno con l’altro, si passa agevolmente alla così detta teoria delle reti, utilizzata per descrivere diversi tipi di reti in fisica, biologia, ecc..

Una catena di spin

Un modello molto interessante in fisica quantistica, descritto proprio con un formalismo di questo genere, è il modello di Ising(2)Nella sua versione più semplice il modello di Ising è descritto dalla seguente sommatoria, che descrive l’energia del sistema:

\(H = \sum_{i,j} J_{ij} \sigma_i \sigma_j + \sum_j h_j \sigma_j\)

Senza scendere eccessivamente nel dettaglio, i vari \(\sigma_i\) rappresentano gli spin dei vari nodi, il termine \(J_{ij}\) l’interazione che avviene tra i vari nodi, \(h_j\) un campo magnetico esterno che agisce sul nodo j-esimo., che viene utilizzato per descrivere una catena o un reticolo di spin, in alcuni casi con l’aggiunta di un campo magnetico esterno. Lo spin è il numero quantistico che è associato alla rotazione di una particella e può assumere due valori, +1/2 e -1/2.

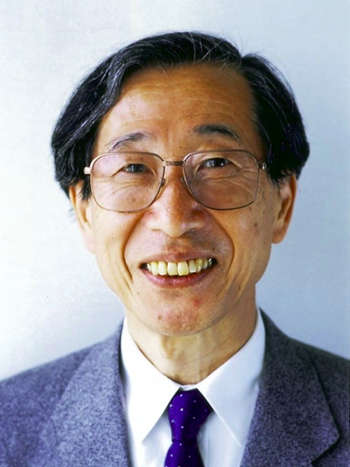

Nel 1972 l’ingegnere matematico Shun’ichi Amari propose un modello di Ising opportunamente modificato per descrivere il funzionamento di una memoria.

Evidentemente il matematico giapponese, in virtù del fatto che il modello di Ising è a due valori, lo ritenne efficace per poter descrivere un primo modello iniziale di rete neurale: in quella fase pionieristica della ricerca, infatti, si tendeva a modellizzare i neuroni utilizzando due semplici stati: 0 per il neurone non-attivo, e 1 per il neurone attivo.

Se reinterpretiamo il modello di Ising in termini di reti neurali moderne, possiamo associare agli spin dei nodi del modello originale gli stati dei neuroni, mentre al campo magnetico esterno quelli che vengono chiamati bias, preconcetti. In questo modo il funzionamento di una rete neurale viene descritto da una funzione particolare, detta funzione di propagazione, che tiene conto del modo in cui i nodi si scambiano le informazioni, dei risultati che ciascun nodo invia agli altri nodi, e dei bias presenti nella rete.

Il lavoro di Amari fu, quindi, una delle prime applicazioni del modello di Ising alla “memoria”(3)In effetti Kaoru Nakano pubblicò risultati simili nel 1971 del modello di Ising alle reti neurali(4)Nello specifico: una memoria associativa, ma non l’unica: seguirono, infatti, William Little nel 1974 e il modello di Sherrington-Kirkpatrick nel 1975.

E infine il modello di Hopfield nel 1982.

La biologia dal punto di vista della fisica

Come molti premi Nobel prima di lui, ha lavorato presso i Bell Labs, anche se solo per un paio di anni, prima occupandosi di semiconduttori, e successivamente sviluppando insieme con Robert Shulman un modello quantitavo che descriveva il comportamento cooperativo dell’emoglobina. Fu quindi ai Bell Labs che Hopfield iniziò a interessarsi di biofisica e matematica delle reti.

La parte più consistente del suo lavoro in questo campo venne svolta presso il Caltech tra il 1980 e il 1987: non a caso l’articolo che gli è valso il Nobel per la fisica 2024, quello in cui descrive quello che è oggi noto come modello di Hopfield, venne pubblicato proprio nel 1982.

Sempre a quel periodo presso il Caltech risale la creazione del corso The Physics of Computation cui Hopfield aveva contribuito insieme con Richard Feynman e Carver Mead. In particolare Hopfield, su esplicito invito di Feynman, si occupò delle lezioni sulle reti neurali associative, che in pratica erano quelle descritte dal suo modello del 1982. Ispirato da questa esperienza, Hopfield contribuì a fondare il programma di dottorato noto come Computation and Neural Systems.

Vorrei a questo punto far notare come il lavoro di un biofisico, interessato a capire le interazioni tra le cellule biologiche (perchè in pratica fu questa l’ispirazione iniziale di Hopfield), è stato fondamentale per dare un impulso importante allo sviluppo delle reti neurali artificiali, popolarmente note come intelligenze artificiali.

Il passo successivo sarebbe, però, arrivato di lì a poco.

Essere discreti a volte non è utile

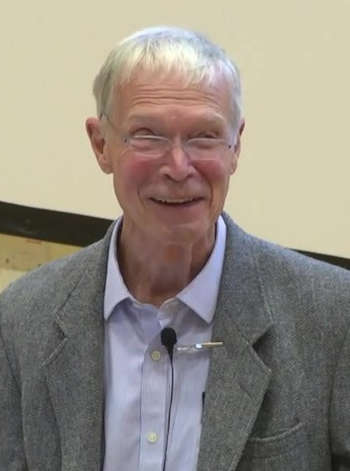

E’ a questo punto della nostra storia che entra in gioco Geoffrey Hinton, che in un certo senso ha “pompato” il modello di Hopfield con una “anfetamina” piuttosto particolare: la termodinamica statistica di Ludwig Boltzmann.

Hinton, nato il 6 dicembre del 1947 nel distretto di Wimbledon, a Londra, nel corso dei suoi studi ha unito la psicologia sperimentale, campo nel quale si è laureato nel 1970, con l’intelligenza artificiale, nel quale si è specializzato nel corso del dottorato conseguito a Edimburgo nel 1978.

Ed è proprio in questo campo che ha sviluppato nel 1985, insieme con David Ackley e Terry Sejnowski, la macchina di Boltzmann, che, ancora una volta, risulta una variazione sul modello di Ising. Le aggiunte dei tre ricercatori, evidentemente suggerite dal fisico Sejnowski, provengono tutte dalla termodinamica di Boltzmann: per esempio le probabilità di cui sopra dipendono esplicitamente da un termine detto “temperatura”.

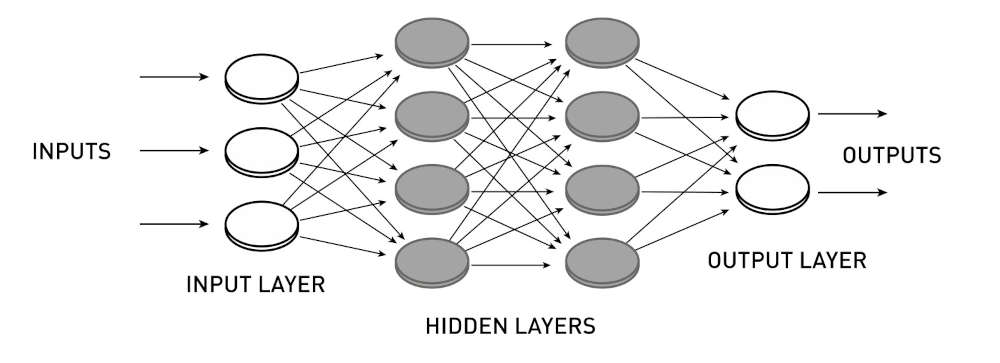

La macchina di Boltzmann ha anche introdotto un’idea che ha ulteriormente permesso alle reti neurali di immagazzinare maggiori informazioni ed elaborarle in maniera più veloce ed efficace: le reti multistrato.

Una macchina di Boltzmann, infatti, è definita come una serie di reti neurali innestate una dentro l’altra. Una parte di queste reti neurali è detta nascosta, poichè non interagisce con l’esterno e riceve i dati da rielaborare dalle altre reti. Solo la rete che riceve gli input e quella che restituisce gli output sono quelle che interagiscono direttamente con gli utilizzatori.

Ovviamente maggiori sono gli strati di una rete siffatta, più profondi saranno i suoi calcoli, o utilizzando un linguaggio più “colorito”, più profondo sarà il suo pensiero. Un po’ come il famoso Pensiero profondo!

Un tale approccio rivoluzionario rese Hinton un’autorità nel campo dell’intelligenza artificiale, tanto che Google gli chiese di collaborare con la sua divisione che sviluppa tecniche di deep learning. Tale collaborazione iniziò nel 2013 e si concluse nel 2023 quando Hinton decise di abbandonare il progetto sbattendo metaforicamente la porta: criticava la direzione di sviluppo che stava prendendo la ricerca sulle reti neurali artificiali, che non prendevano in considerazione eventuali rischi legati a questa tecnologia.

In un certo senso queste preoccupazioni riecheggiano nelle dichiarazioni che lo stesso Hopfield ha rilasciato all’agenzia AFP dopo aver ottenuto il Nobel per la Fisica:

Ripiegare proteine

Hassabis è, in un certo senso, un simbolo stesso della nostra società multietnica. E’ nato, infatti, il 27 luglio del 1976 da un padre greco-cipriota e da una madre cino-singaporeana (scusate per questo neologismo che prova a rendere singaporean chinese). A 4 anni si rivela un prodigio degli scacchi, dettaglio che in qualche modo spiega la direzione delle sue ricerche, che oggi porta avanti proprio per Google.

Studia a Cambridge e si interessa di computer science e videogame. Non a caso i suoi primi posti di lavoro sono proprio con aziende che operano in quel campo: basti come esempio citare i due giochi di simulazione Republic: The Revolution ed Evil Genius.

Successivamente ritorna agli studi accademici, ottenendo il dottorato in neuroscienze nel 2009 presso la UCL (University College London). Da qui inizia un percorso che lo porta a fondare, nel 2010, insieme con Shane Legg e Mustafa Suleyman, la startup Deep Mind specializzata nel machine learning, ovvero tutte le tecniche matematiche e informatiche di addestramento delle reti neurali. La società viene acquisita da Google nel 2014, ottenendo così un grande impulso nella sua attività di ricerca, arrivando a rivoluzionare l’approccio al deep learning con due software particolarmente famosi: AlphaZero e AlphaGo.

In particolare AlphaZero, che possiamo definire in maniera riduttiva “motore scacchistico”, è diventato in questo campo il migliore in assoluto grazie a tecniche di autoaddestramento: la rete neurale progettata da Depp Mind ha, infatti, giocato centinaia di migliaia di partite partendo proprio da zero, a parte le regole di base del gioco. Alla fine ha semplicemente imparato dai suoi stessi errori, raggiungendo quindi un livello tale da riuscire a scoprire nuove tecniche di gioco oggi entrate nel bagaglio di molti dei migliori scacchisti al mondo. Lo stesso approccio è stato poi applicato per AlphaGo, una rete neurale specializzata nel gioco cinese del go.

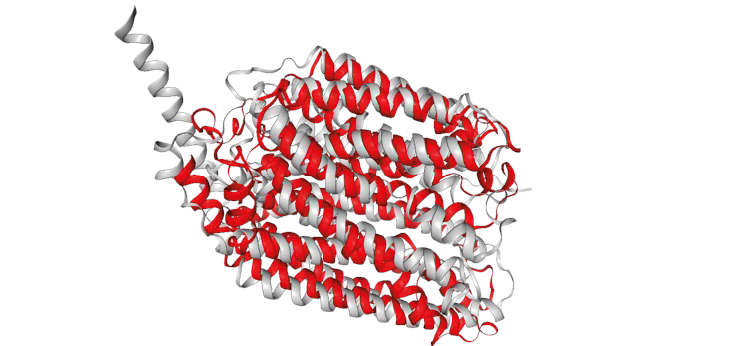

Dimostrato, così, il principio, Google e Deep Mind hanno ritirato le due reti neurali, che nel frattempo avevano raggiunto la cima nei rispettivi campi, per concentrarsi su quello che oggi possiamo considerare il loro vero obiettivo: progettare reti neurali in grado di “fare ricerca”. Il primo esperimento, peraltro di successo, è indubbiamente AlphaFold, una rete neurale specializzata nello studio delle proteine e di come esse si ripiegano su se stesse. Che poi è proprio per questo che Hassabis ha ottenuto il Premio Nobel per la Chimica.

Nel frattempo, nella serie Alpha, Deep Mind ha iniziato a sviluppare AlphaGeometry, che ha l’obiettivo di risolvere problemi di geometria euclidea particolarmente ostici. Se consideriamo che le dimostrazioni matematiche presentano un livello di creatività e di astrazione piuttosto alti, quest’ultima sfida risulta ancora più probante rispetto ai suoi precedenti “fratelli”. Si concluderà anche questa con successo? Solo il tempo ce lo dirà .

Note

| ↑1 | A puro titolo di esempio vi mostro un’equazione tipica della teoria delle reti:

\(\sum_{i=1}^n a_i w_{ij}\)

|

|---|---|

| ↑2 | Nella sua versione più semplice il modello di Ising è descritto dalla seguente sommatoria, che descrive l’energia del sistema:

\(H = \sum_{i,j} J_{ij} \sigma_i \sigma_j + \sum_j h_j \sigma_j\)

Senza scendere eccessivamente nel dettaglio, i vari \(\sigma_i\) rappresentano gli spin dei vari nodi, il termine \(J_{ij}\) l’interazione che avviene tra i vari nodi, \(h_j\) un campo magnetico esterno che agisce sul nodo j-esimo. |

| ↑3 | In effetti Kaoru Nakano pubblicò risultati simili nel 1971 |

| ↑4 | Nello specifico: una memoria associativa |

| ↑5 | And as a physicist, I’m very unnerved by something which has no control, something which I don’t understand well enough so that I can understand what are the limits which one could drive that technology. |

Add Comment